6 aspectos basicos de la inteligencia artificial generativa

Explorar las capacidades de la IA generativa

ChatGPT puede responder en lenguaje sencillo, generar contenido relacionado con texto (GPT: transformador generativo preentrenado: modelo de lenguaje grande).

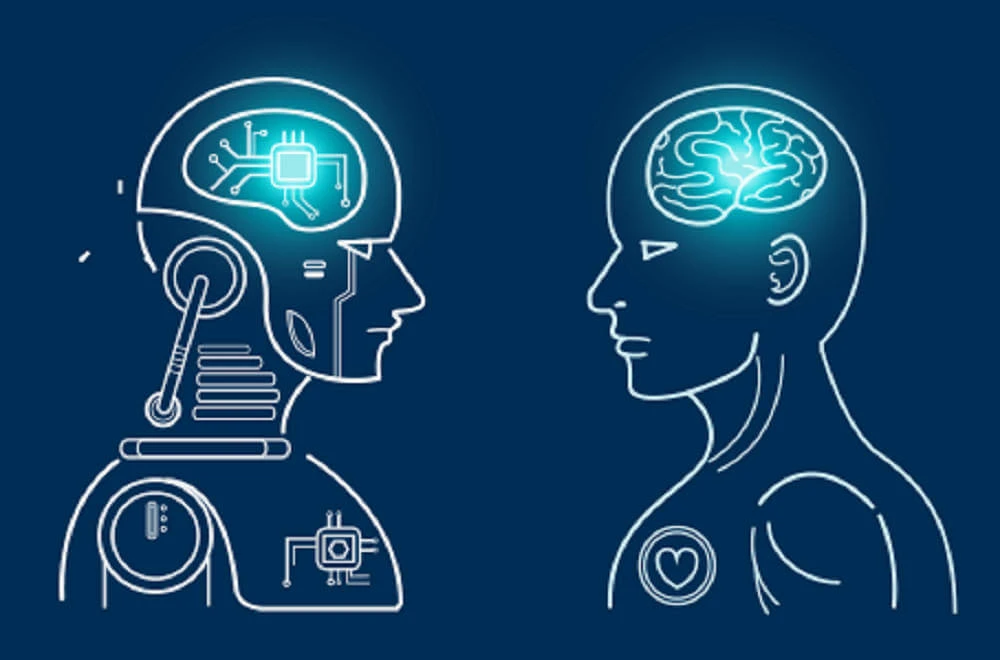

Si bien un tipo o modelo de IA puede generar una predicción numérica o un número en base a datos a los que tenga acceso o con los que se haya entrenado, hay otro tipo de IA que es capaz de producir más que un número. Pueden producir texto, imágenes y sonidos que no se han escuchado nunca, y que pueden cambiar las cosas.

Entrenamiento e interpretación de texto

El entrenamiento de interpretación de texto involucra la combinación de palabras (procesamiento del lenguaje natural, PLN). Algunos modelos de IA que realizan tareas de PLN se entrenan con grandes cantidades de datos (escritos por personas). La fuente de entrenamiento es internet. Como estos modelos de IA se entrenan con grandes cantidades de datos, se llaman grandes modelos de lenguaje (LLM).

Tareas de lenguaje

Sintetización: Un generador de pitch de elevador definitivo puede hacer un resumen, ya que puede cambiar las palabras o reescribir la frase porque comprende la sintaxis y el significado de las palabras.

Traducción: También es capaz de traducir la intención que se intenta comunicar con palabras en un idioma, gracias a que se entrenan con las reglas de cada idioma. Entonces, cuando se intenta expresar la misma idea, usa el segundo conjunto de reglas o idioma.

Los LLM son como una colección de reglas que describen cómo estructurar un idioma para convertir palabras en ideas.

Corrección de errores: La IA entiende el contexto o la idea del texto o sonido y puede cambiar automáticamente las palabras que no están bien escritas o mejorar los subtítulos.

Respuesta a preguntas: La IA es capaz de interpretar la intención de una pregunta o solicitud y, a partir de ahí, generar una cantidad de texto basado en la solicitud puntual.

Generación guiada de imágenes: Los LLM pueden usarse junto con modelos de generación de imágenes. Solo se escribe la descripción de la imagen y se genera una imagen basada en la información que hay en internet. También se puede agregar contenido nuevo a imágenes.

Texto a voz: Se puede adaptar un texto para que la IA imite cómo habla una persona, basado en los patrones que usa al hablar.

Predicciones impresionantes: Aunque genera un texto, eso que genera es una predicción. Esa predicción no es el valor de algo, sino que es algo que quizá tenga valor para el usuario. Recuerda que el ordenador no piensa, solo está bien entrenado, por lo que puede responder a preguntas como: "¿quieres té o café?" por medio de predicciones.

Entender el ecosistema tecnológico de la IA generativa

Potenciar el entrenamiento de la IA generativa

3 Factores: datos, arquitectura y computación

1. Disponibilidad de grandes cantidades de datos: Fuente de entrenamiento y ejemplos de redacción.

2. Un mejor entrenamiento para usar los datos: Las redes neuronales entrenan a los modelos. En 2017 se publicó un documento que proponía una nueva arquitectura de red neuronal conocida como transformador. La nueva arquitectura fue capaz de identificar relaciones importantes entre las palabras, sin importar lo lejos que aparecieran dentro de un bloque de texto. Podía mantener esa conexión incluso después de procesar muchas palabras.

3. Potencia de procesamiento: Se requiere para la ejecución de cálculos que son realizados uno tras otro por los modelos de IA (para su entrenamiento históricamente). En cambio, la arquitectura de los transformadores es distinta porque se basa en muchos cálculos separados y simultáneos. Un procesador se ocupa de un cálculo mientras otro procesador se ocupa de otro cálculo al mismo tiempo. Esto se llama computación paralela.

Ecosistema emergente

Cada vez son más los sitios donde se encuentra la IA generativa. Aquí vemos los elementos de la pila tecnológica necesarios para la IA generativa:

Potencia computacional: Incluso la arquitectura de los transformadores requiere procesamiento. Los procesadores que son capaces de usar computación paralela son requeridos.

Las plataformas de nube permiten que los desarrolladores aprovechen el hardware informático en un modelo de implementación en la nube. Los desarrolladores pueden reservar la cantidad de tiempo adecuada para un proyecto específico, y las plataformas pueden distribuir de forma eficaz las solicitudes de tiempo de computación a través de un sistema conectado.

Modelos de IA: Incluidos los LLM, constituyen la capa siguiente. Estos modelos se elaboran cuidadosamente mediante técnicas de investigación y se entrenan combinando datos depurados públicos y privados. Los desarrolladores pueden conectarse a los LLM a través de una interfaz de programación de aplicaciones (API), para aprovechar toda la potencia del procesamiento de lenguaje natural (PLN) en sus propias aplicaciones. El modelo de IA entrenado y accesible suele denominarse modelo fundacional. Dado que se accede a estos modelos a través de una API, los desarrolladores pueden cambiar fácilmente de un modelo fundacional a otro según sea necesario.

Optimización de la infraestructura: Proporciona herramientas y servicios que permiten un entrenamiento de modelos más eficaz y de mayor calidad (ejemplos: datos depurados, análisis y especificación en datos de la empresa).

Aplicaciones: Los desarrolladores pueden aprovechar los servicios de optimización y los modelos fundacionales para sus aplicaciones.

Problemas de la IA generativa

Alucinaciones: Es posible que la respuesta esperada basada en hechos no sea correcta ya que los datos usados para el entrenamiento eran incorrectos o estaban sesgados, o porque no se diseñó bien el modelo. Tener cuidado con las respuestas de la IA.

Seguridad de datos: Las empresas pueden compartir datos propios en dos puntos del ciclo de vida de la IA generativa. Primero, cuando ajustan un modelo fundacional. Segundo, cuando usan el modelo para procesar una solicitud con datos confidenciales. Las compañías que ofrecen servicios de IA deben demostrar que la confianza es primordial y que los datos estarán siempre protegidos.

Plagio: Agregar variación al contenido generado por LLM y modelos generadores de imágenes. También es posible que tenga que depurar datos del entrenamiento para eliminar muestras si lo piden los creadores de contenido.

Suplantación de identidad del usuario: Ahora es más difícil identificar las redes de bots que promocionan el contenido de una empresa.

Sostenibilidad: A medida que crecen los modelos de IA, requieren más procesadores y eso produce una huella de carbono. Aunque cuando los modelos ya están entrenados, no es grande el consumo.